Nous entretenons tous des biais.

De la route que nous empruntons pour revenir à la maison à l’endroit que nous choisissons pour aller dîner, nous avons tous nos préférences inhérentes qui nous prédisposent à prendre des décisions particulières.

Même si nous avons l’impression que nos choix sont rationnels, nous savons que ce n’est pas toujours le cas. Dans certains cas, nous ne sommes même pas en mesure d’expliquer pourquoi nous préférons une option à une autre.

Si ce comportement est acceptable quand vient le temps de choisir entre un Coke et un Pepsi, la situation est autrement différente lorsque nous demandons à un système d’intelligence artificielle (IA) de poser des jugements et de faire des prédictions qui portent à conséquence pour les humains.

Comme les biais persistent dans tous les domaines de la société, il n’est pas surprenant qu’on en trouve aussi en IA.

Il y a plus de 50 ans, l’informaticien Melvin Conway a constaté que la structure interne des organisations exerce une forte influence sur les systèmes qu’elles mettent sur pied. Cette observation, aujourd’hui connue comme la « loi de Conway », se vérifie également pour l’IA. Les valeurs des personnes qui développent des systèmes ne sont pas seulement profondément enracinées : elles sont aussi concentrées.

Au Canada, l’expertise en IA se polarise essentiellement autour de trois villes : Edmonton, Toronto et Montréal. Chacune d’elles héberge un pionnier de l’IA vers lequel ont convergé les gens et les sources de financement.

Sur le plan économique, cette concentration a suscité une compétitivité accrue et agi comme un aimant attirant et retenant les meilleurs talents en IA.

Et c’est efficace! À l’Institut canadien de recherches avancées (CIFAR), plus de la moitié des titulaires de chaires de recherche ont été recrutés au Canada. Mais cette concentration soulève également des défis que le Canada et les autres centres mondiaux en IA tentent de relever.

Ces « tribus » de l’IA sont extrêmement homogènes, comme l’a constaté Amy Webb, futurologue et auteure. Les membres de ces regroupements ont fréquenté les mêmes universités, ils sont aisés et fortement scolarisés, et ce sont très largement des hommes.

Cette constatation a été confirmée par le plus récent rapport mondial sur l’écart entre les genres publié par le Forum économique mondial, qui révèle que seulement 22 % des professionnels de l’IA à l’échelle mondiale sont des femmes. Au Canada, cette proportion n’est guère meilleure, avec 24 % de femmes.

Ce déséquilibre des genres est encore plus marqué lorsqu’on examine la constitution des cohortes de chercheurs en IA. Selon une étude réalisée par Element AI, on compte en moyenne neuf hommes pour chaque femme dans le secteur de la recherche en IA.

Mais surtout, la nature même du développement de l’IA fait en sorte que les systèmes d’IA apprennent ce que les données leur donnent à voir et héritent des biais inconscients de leurs créateurs.

C’est ainsi que le déséquilibre entre hommes et femmes en IA trouve un écho dans les systèmes en cours de développement. Par exemple, un système de reconnaissance visuelle qui avait été entraîné à partir d’un ensemble de données associant la préparation des aliments 33 % plus souvent aux femmes qu’aux hommes a amplifié cette disparité pour la porter à 68 %.

Les « tribus » de l’IA ont également, de façon prépondérante, la peau blanche.

Dans un rapport publié en avril, l’AI Now Institute révèle que seulement 2,5 % de l’effectif de Google et 4 % de celui de Facebook et de Microsoft ont la peau noire, et que les données sur la présence de membres de la communauté LGBTQ en IA sont inexistantes – une situation que l’organisme qualifie de « catastrophe sur le plan de la diversité ».

En tant que membres d’une société multiculturelle, tous les Canadiens devraient se sentir interpellés par le manque de diversité en IA.

Que ce soit dans le calcul des primes d’assurance, le maintien de l’ordre, la prestation de soins de santé ou le traitement des demandes d’admission dans les écoles, pour ne citer que ces exemples, cet enjeu devient chaque jour plus pressant, à mesure que l’IA s’intègre à la trame de notre société.

Gartner prédit qu’au cours des prochaines années, 85 % des projets en IA produiront des résultats erronés en raison des biais qui affectent les données, les algorithmes et les équipes qui en assurent la gestion.

Nous ne pouvons pas nous offrir le luxe d’éviter les discussions inconfortables sur le sexisme, le racisme et nos autres biais inconscients, ou sur les voies par lesquelles ces biais s’immiscent en IA.

Supposons par exemple qu’une entreprise médicale souhaite mettre au point un système d’IA capable de déterminer le meilleur plan de traitement pour les patients. Pour ce faire, l’entreprise doit définir son objectif. S’agit-il de minimiser le coût des traitements? S’agit-il plutôt de maximiser les résultats thérapeutiques pour les patients?

Si le but est de minimiser les coûts, l’algorithme pourrait conclure qu’une façon efficace d’y parvenir consiste à recommander des traitements moins efficaces, sélectionnés en calculant le meilleur rapport « probabilité de succès/prix ».

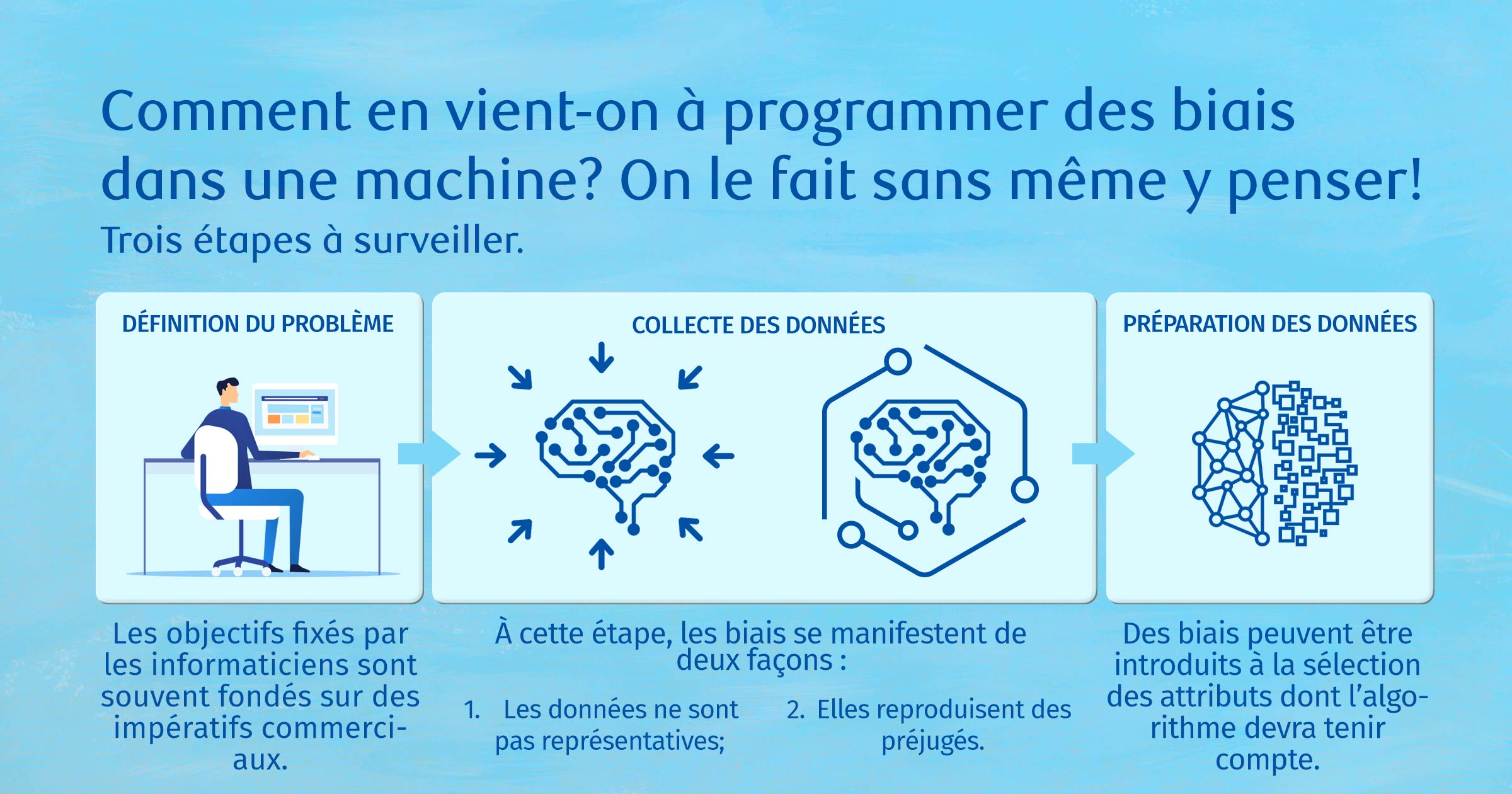

Lorsque des entreprises fixent des objectifs à leurs systèmes d’IA, que ce soit pour des traitements médicaux personnalisés ou d’autres applications, ces décisions sont souvent fondées sur des impératifs commerciaux, et non pas sur des préoccupations liées à l’équité ou à la discrimination.

Des biais peuvent également s’introduire par les méthodes de collecte des données. Si les données recueillies ne sont pas représentatives ou sont influencées par des préjugés, il est possible d’introduire un biais racial alors même qu’on a pris

la précaution d’éviter l’origine raciale comme facteur d’entrée explicite.

Par exemple, une recherche menée par Centraide dans le Grand Toronto a constaté que les indicateurs d’inégalité et de race sont de plus en plus liés aux codes postaux dans la région de Toronto. Une organisation qui souhaiterait éviter l’identification raciale pourrait donc tout de même produire des résultats déficients si elle utilisait les codes postaux comme données d’entrée.

Un autre problème est que tous les résultats produits par les systèmes d’IA ne sont pas facilement explicables. Les entreprises veulent se doter de systèmes qui produisent les prédictions les plus exactes possible, mais ces modèles sont aussi les plus complexes et les plus difficiles à comprendre.

Même les ingénieurs qui ont conçu les systèmes qui nous suggèrent de la musique ou qui choisissent les publicités les plus susceptibles de nous plaire ne peuvent expliquer complètement comment leurs modèles produisent ces recommandations. Cette situation peut être tolérable lorsqu’elle concerne des listes de lecture recommandées par Spotify, mais à quel point serons-nous disposés à accepter des conseils médicaux d’un système fondé sur l’IA?

C’est le défi que les chercheurs qui ont mis au point le système Deep Patient ont tenté de relever. Ce système, entraîné à partir de données provenant de 700 000 patients, produisait de très bonnes prédictions sur les malades, y compris le cancer du foie de stade I. Cependant, les chercheurs étaient incapables d’expliquer comment le système en arrivait à ces conclusions.

En l’absence d’explicabilité, une équipe médicale accepterait-elle d’intervenir sur la foi de ces prédictions? Les praticiens seraient-ils disposés à changer des régimes de médication, à administrer des traitements de chimiothérapie ou à pratiquer des interventions chirurgicales?

L’enjeu central n’est pas l’IA, mais la façon dont nous construisons les systèmes d’IA.

Nous devons reconnaître la présence des grands enjeux sociaux dans les données humaines recueillies et les éliminer avant qu’ils ne soient intégrés au code des systèmes. À l’heure actuelle, la présence des biais est souvent abordée après coup, comme un problème qui doit être résolu à la fin du cycle de développement.

Au contraire, il faudrait intégrer des experts des questions sociales à toutes les étapes du cycle de développement pour qu’ils collaborent étroitement au travail des experts responsables du codage.

Nous devons traiter les systèmes d’IA comme de nouveaux produits pharmaceutiques : leur faire subir des essais rigoureux pour comprendre leurs effets néfastes potentiels et repérer tout biais qui pourrait en affecter les résultats, avant que ces systèmes ne soient mis en application.

De plus, l’évaluation des systèmes devrait se poursuivre après leur lancement. Les systèmes d’IA doivent être surveillés en continu et réévalués à intervalles réguliers tout au long de leur cycle de vie. Une étude sur la demie-vie des données médicales montre que la vie des données cliniques est très courte et que leur utilité décline très rapidement. Après à peine quatre mois, un système d’IA pourrait prendre des décisions fondées sur des données périmées, entraînant des conséquences graves pour la population.

Mais quelle que soit la peur qu’inspirent l’IA et son impact sur l’avenir de l’humanité, toute solution possible pour atténuer les biais et améliorer les systèmes d’IA exige une intervention humaine.

Les « systèmes avec intervention humaine » – une expression technique désignant des systèmes qui ne sont pas entièrement autonomes – sont fondés sur une relation symbiotique entre les humains et l’IA. Ces systèmes sont mis en œuvre dans des contextes où le niveau de confiance est faible et les conséquences des erreurs sont graves, par exemple en santé.

Chaque fois que le niveau de certitude d’une décision est faible, le système demande l’assistance d’un intervenant humain. Cet aspect est essentiel dans le secteur des soins de santé, où des praticiens doivent interagir avec les résultats du système. Leur participation accroît l’explicabilité des résultats et le niveau de confiance associé à leur exploitation pour des gestes thérapeutiques.

Chose certaine, des humains doivent se trouver au cœur du développement de l’IA.

Publiée en décembre 2018, la Déclaration de Montréal pour un développement responsable de l’intelligence artificielle expose un cadre éthique qui recommande l’élaboration de lignes directrices en matière d’IA afin de veiller à ce que son développement « soit conforme à nos valeurs humaines et porteur d’un véritable progrès social ». Cette déclaration a été signée par 45 organismes et 1 394 citoyens.

Plus tôt cette année, le Conseil de l’Europe a adopté sa propre déclaration sur l’intelligence artificielle, qui presse les États d’assurer « l’égalité et la dignité de tous les êtres humains en tant qu’agents moraux indépendants » dans un monde qui s’appuie sur l’IA.

Aux États-Unis, des législateurs ont proposé l’Algorithmic Accountability Act (loi sur la responsabilité en matière d’algorithmes), qui exige que certaines entreprises – celles dont les revenus annuels excèdent 50 millions de dollars et qui détiennent de l’information sur au moins 1 million d’individus ou d’appareils, ainsi que celles qui agissent principalement à titre d’intermédiaires pour l’achat et la vente de données sur les consommateurs – procèdent à des audits de leurs systèmes pour y détecter les biais.

Mais qui exigera des signataires de ces déclarations qu’ils rendent des comptes? Ce rôle sera-t-il assumé par les gouvernements, qui supervisent l’utilisation de l’IA au sein des organismes gouvernementaux? Qu’adviendra-t-il si des gouvernements divergent d’opinion quant au mode de déploiement de l’IA?

Il existe deux principaux courants à l’échelle mondiale en matière d’utilisation de l’IA. Le premier, principalement soutenu par les entreprises de la Silicon Valley, met l’accent sur le consumérisme et la création de valeur. L’autre nous vient d’Asie, où le gouvernement chinois voit l’IA comme un instrument de gouvernance sociale.

Ces questions et défis offrent au Canada la possibilité d’ouvrir la voie et de devenir un chef de file de l’avancement de l’IA pour le bien commun. Il s’agit de l’une de nos 10 recommandations visant à préparer le Canada à l’IA.

Même si le Canada a été le premier pays à se doter d’une stratégie nationale en matière d’IA, nous avons pris du retard dans la mise à profit et la commercialisation de ses applications. L’adoption d’une stratégie d’IA pour le bien commun, proposée en parallèle au soutien de la supergrappe canadienne d’expertise en IA, et la mise sur pied d’une stratégie nationale relative aux données, très attendue dans les milieux concernés, pourraient renforcer la compétitivité du Canada à titre de centre mondial en IA et nou

s aider à faire valoir notre position de chef de file dynamique de l’intelligence artificielle.

Nous devons toutefois accepter de soulever des questions embarrassantes.

L’IA est un miroir de la société qui nous oblige à examiner avec rigueur les mensonges polis avec lesquels nous nous rassurons. Nous ne pouvons plus nous permettre de détourner le regard.

John Stackhouse est un auteur à succès et l’un des grands spécialistes en matière d’innovation et de perturbations économiques au Canada. À titre de premier vice-président, Bureau du chef de la direction, il dirige la recherche et exerce un leadership avisé concernant les changements économiques, technologiques et sociaux. Auparavant, il a été rédacteur en chef du Globe and Mail et éditeur du cahier « Report on Business. » Il est agrégé supérieur de l’institut C.D. Howe et de la Munk School of Global Affairs and Public Policy de l’Université de Toronto, en plus de siéger aux conseils d’administration de l’Université Queen’s, de la Fondation Aga Khan Canada et de la Literary Review of Canada. Dans son dernier livre, « Planet Canada: How Our Expats Are Shaping the Future », il aborde la ressource inexploitée que représentent les millions de Canadiens qui ne vivent pas ici, mais qui exercent leur influence depuis l’étranger.

Le présent article vise à offrir des renseignements généraux seulement et n’a pas pour objet de fournir des conseils juridiques ou financiers, ni d’autres conseils professionnels. Veuillez consulter un conseiller professionnel en ce qui concerne votre situation particulière. Les renseignements présentés sont réputés être factuels et à jour, mais nous ne garantissons pas leur exactitude et ils ne doivent pas être considérés comme une analyse exhaustive des sujets abordés. Les opinions exprimées reflètent le jugement des auteurs à la date de publication et peuvent changer. La Banque Royale du Canada et ses entités ne font pas la promotion, ni explicitement ni implicitement, des conseils, des avis, des renseignements, des produits ou des services de tiers.

Voir Plus

Voir Plus